Jamstack : déployer plus vite, scaler sans stress, penser autrement

On croyait avoir tout essayé. Du fullstack monolithique aux microservices déchaînés.

Et puis est arrivée cette drôle de bête : la Jamstack. Une architecture sans backend... ou presque. Pas vraiment nouvelle, pas tout à fait tendance. Juste terriblement adaptée à une époque où chaque milliseconde compte.

Elle ne vend pas du rêve. Elle vend du delivery. Et ça change tout. Alors, simple hype ou vraie rupture dans la façon de construire le web ?

Jamstack sous le capot : comment cette architecture redéfinit les règles du jeu

Une définition claire : découplée, pré-rendue, distribuée

Jamstack repose sur un trépied architectural : JavaScript, APIs et Markup. Pas un framework. Pas une stack technologique imposée. Plutôt une façon d’organiser le web autrement.

JavaScript pour le comportement côté client.

APIs pour la logique distante, appelable à la demande.

Markup pour le contenu, souvent généré à la volée lors du build, puis servi sous forme de fichiers statiques.

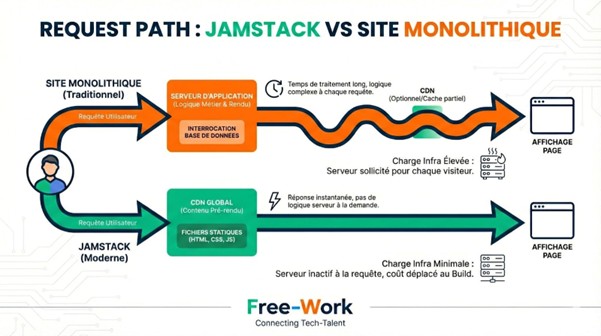

Dès lors, on ne construit plus une application « vivante » sur le serveur. On pré-construit des pages prêtes à l’emploi, distribuées ensuite via CDN. Le code devient un produit fini, pas un service en attente de requêtes.

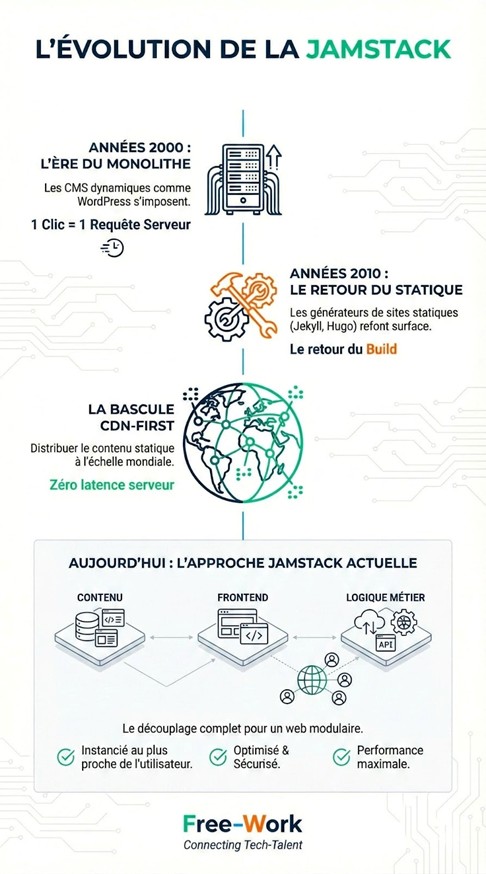

Retour aux origines : comment on en est arrivé là

La Jamstack émerge d’un besoin ancien : rendre plus vite, avec moins.

Années 2000 : les CMS dynamiques comme WordPress s’imposent. Chaque clic déclenche une requête serveur.

Années 2010 : les générateurs de sites statiques (Jekyll, Hugo) refont surface. Le retour du build.

Puis arrive la bascule CDN-first : distribuer le contenu statique à l’échelle mondiale, sans latence serveur.

Aujourd’hui : l’approche Jamstack embrasse le découplage complet – contenu, frontend, logique métier – pour composer un web modulaire, optimisé, instancié au plus proche de l’utilisateur.

Comment fonctionne la Jamstack (vraiment) ?

Le build constitue le point de départ. Une fois lancé, il pré-génère l’ensemble des pages en HTML, en y injectant les données disponibles (depuis un CMS headless, une base, un fichier markdown…).

Ensuite, le déploiement propulse ces pages sur un CDN, réparti sur des dizaines (parfois des centaines) de PoP (Points of Presence) dans le monde. Résultat : une navigation quasi instantanée, sans serveur à interroger.

Et le dynamique dans tout ça ? Il se gère côté client, via hydration JavaScript, ou en différé, via des APIs appelées à la volée.

Un besoin de formulaire, de panier ou d’interaction ? Un microservice serverless prend le relai. Rien ne vit sur un serveur applicatif monolithique.

JavaScript, APIs, Markup : les trois piliers (et leurs implications réelles)

JavaScript, dans la Jamstack, ne se limite pas à quelques animations. Il orchestre tout ce qui sort du domaine purement statique : hydration du DOM, appels API, rendering conditionnel… Bref, il reconnecte le site au monde dynamique.

APIs : elles incarnent la logique métier. Authentification, gestion de sessions, paniers, calculs… Tout passe par des endpoints, souvent hébergés en serverless. Résultat : on découple, on mutualise, on cache.

Markup : c’est le cœur pré-rendu. HTML généré au build, enrichi au besoin par des systèmes comme :

SSG (Static Site Generation)

ISR (Incremental Static Regeneration)

DPR (Distributed Persistent Rendering)

Chaque mécanisme ajuste le curseur entre performance, fraîcheur des données et scalabilité.

Avantages et zones d’ombre : Jamstack, la promesse à disséquer

Pourquoi ça va vite, et pourquoi ça compte ?

Le combo build statique + CDN tire les temps de chargement vers le bas. Pas d’appel serveur, pas de calcul runtime : tout est prêt avant la requête !

👉 Résultat :

TTFB quasi instantané

Interactivité immédiate via hydration

Score Lighthouse qui frôle le 100

Les Core Web Vitals sourient à la Jamstack :

Largest Contentful Paint ? Moins d’une seconde.

Cumulative Layout Shift ? Inexistant sur du HTML pur.

First Input Delay ? Négocié côté JS.

Des landing pages aux sites e-commerce headless, les cas d’usage sont pléthore.

Sécurité : une surface d’attaque réduite à l’os

Aucun serveur applicatif exposé. Pas de base de données à injecter. Pas de login admin à protéger en prod.

La Jamstack coupe l’herbe sous le pied des attaques traditionnelles. XSS, injections SQL, escalades de privilèges : moins de vecteurs, moins d’angles morts.

Ajoutez à cela un CDN avec couche WAF, anti-DDoS et gestion de certificats automatisée : la sécurité devient structurelle.

Scalabilité : une croissance sans douleur

Le modèle statique distribué repose sur une vérité simple : le même HTML peut répondre à un million d’utilisateurs.

Plus besoin de dimensionner un backend. Le CDN absorbe les pics, horizontalement. Moins d’Ops, moins d’alertes à 3h du matin, moins d’infra à patcher.

Pour un site e-commerce headless par exemple, cela signifie :

build unique

cache intelligent

APIs sous Cloudflare Workers ou AWS Lambda

Les limites réelles (pas toujours visibles à première vue)

Aucune architecture n’échappe aux compromis. Jamstack non plus.

Voici ce qui freine parfois l’adoption ou l’exécution fluide :

Build longs dès qu’on approche le millier de pages

Complexité croissante des workflows CI/CD (preview, ISR, edge functions…)

Dépendance aux APIs tierces (latence, downtime, billing…)

Dans quels cas la Jamstack brille — et quand il vaut mieux l’éviter

Les terrains de jeu naturels de la Jamstack

Certaines typologies de projets s’emboîtent parfaitement dans l’architecture Jamstack. Pas besoin de hacks. Pas de contorsions. Le modèle statique découplé s’impose comme une évidence.

Documentation technique. Markdown versionné sur Git, rendu statique, déploiement automatique à chaque merge. Le combo parfait. Les docs produits, les portails d’API, les manuels techniques bénéficient d’un temps de chargement minimal et d’une indexation optimale.

Sites marketing SaaS. Ici, ce sont la vitesse et la stabilité qui priment. Landing pages, pages de pricing, blog produit : tout peut être pré-rendu, stylisé, et livré mondialement sans friction.

Blogs tech et contenus éditoriaux. Avec un headless CMS (Contentful, Sanity, Ghost…), le contenu évolue sans toucher au code. Les builds s’automatisent, les pages s’actualisent à la volée, le SEO reste solide.

E-commerce headless. À condition de maîtriser les mécanismes ISR et cache dynamique, la Jamstack devient une alliée de poids. Chaque page produit peut être pré-rendue, mise en cache, revalidée sans rebuild massif. Les données sensibles (stock, panier, checkout) se traitent côté API, hors du rendu initial.

Quand la Jamstack complexifie plus qu’elle ne simplifie

Jamstack ne constitue pas une réponse universelle. Dès qu’un projet repose sur de fortes interactions côté utilisateur ou sur une logique d’instantanéité, les choses se corsent.

Backoffice ou CRM intensif. Tableaux dynamiques, formulaires imbriqués, accès rôles, filtres complexes… Les interfaces de gestion nécessitent un état applicatif lourd. Recharger une page pré-rendue via des appels API pour chaque champ modifié devient vite contre-productif.

Applications temps réel. Chat en direct, données de marché en streaming, dashboards auto-refresh… Ce sont des cas où le rendu doit s’actualiser au rythme des flux. Là, le modèle statique devient clairement un fardeau.

Multi-tenant complexe. Gérer plusieurs instances personnalisées d’une même application, avec des règles métiers propres, des contenus différenciés et des chemins de build conditionnels ? Cela complique le déploiement, surcharge le cache, et ralentit les temps de build.

Et maintenant ? Vers quoi évolue la Jamstack ?

La frontière Jamstack / full-stack se brouille

Next.js, Nuxt, Astro, Remix... Ces frameworks hybrides ont rendu flou le périmètre du « statique pur ». On parle encore de Jamstack, mais le SSR (Server-Side Rendering) fait son retour en force, souvent couplé à du streaming ou de l’edge rendering.

De fait, le mot Jamstack commence à laisser place à des notions plus larges :

Front-end cloud

Edge-first web

Composable architecture

Plus question de dogme. On compose, on mixe, on arbitre. Le build statique reste là, mais il partage désormais la scène.

CDN intelligents, fonctions edge : la stack se rapproche de l’utilisateur

Les CDN modernes (Cloudflare, Fastly, Akamai) ne se contentent plus de servir des fichiers. Ils exécutent du code, filtrent les requêtes, injectent des entêtes, manipulent les cookies. Au plus proche de l’utilisateur.

Caching avancé. TTL dynamique, purge ciblée, revalidation partielle. Les CDN deviennent des routeurs logiques à part entière.

Fonctions edge. On peut désormais exécuter une fonction serverless… au bord du réseau. En quelques millisecondes.

Authentification, A/B testing, géolocalisation, réécriture conditionnelle : tout peut s’opérer avant d’atteindre le serveur principal (quand il existe encore).

Jamstack côté entreprise : industrialiser sans perdre le contrôle ?

Adopter la Jamstack à grande échelle exige plus qu’un bon framework. Il faut gouverner, monitorer, anticiper. Les problématiques changent de nature :

Gouvernance du contenu. Avec des CMS découplés, des sources multiples (markdown, API, CMS, spreadsheet…), il devient nécessaire d’unifier la taxonomie, la validation, les workflows éditoriaux.

Observabilité. Le debug ne se limite plus à un serveur central. Il faut suivre les logs d’une edge function au Canada, les métriques du build lancé en Asie, les appels API dans le cache de Cloudflare.

Sécurité des APIs. Jetons exposés dans le code, secrets GitHub mal protégés, appel non chiffré… La Jamstack ouvre de nouveaux vecteurs. L’entreprise doit outiller, former, cloisonner.

Ainsi, la Jamstack ne constitue ni une mode, ni un standard universel. Elle incarne une bascule mentale : celle d’un web pensé comme produit livré, non comme service exécuté. Pré-rendu, découplé, distribué — ce modèle s’adapte à une économie du delivery, rapide, granulaire, scalable par défaut.

Pour autant, il exige rigueur, outillage et maîtrise des compromis. L’adopter, ce n’est pas fuir la complexité : c’est la déplacer ailleurs. À chacun d’en évaluer l’opportunité !

Commentaire

Connectez-vous ou créez votre compte pour réagir à l’article.