Cloud hybride, edge computing et DevOps : quelles compétences pour rester à la pointe ?

Kubernetes partout, mais pas seul : Terraform codifie, Argo CD versionne, l’edge déploie localement, le serverless absorbe les pics. Sur Free-Work, les profils qui maîtrisent cet écosystème gagnent du terrain, négocient mieux, tracent des trajectoires rapides. Vous visez le Graal : robustesse, portabilité, sécurité, coûts sous contrôle. Cet article cartographie les technologies, les frameworks et les soft skills qui, en 2025, segmentent les ingénieurs recherchés du reste du marché. Objectif : des décisions actionnables, dès aujourd’hui !

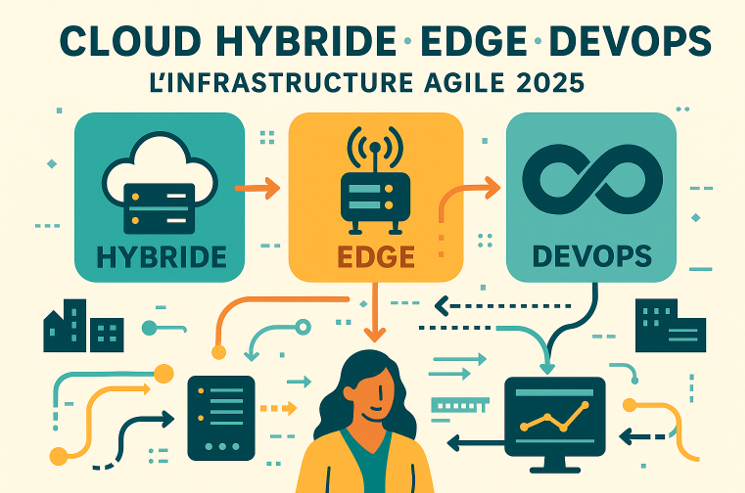

Des environnements toujours plus complexes : cloud hybride, edge computing et DevOps en convergence

Cloud hybride : la norme pour les architectures modernes

Les infrastructures informatiques ne se centralisent plus. Elles s'étendent, se dédoublent, s’entrelacent.

Le cloud hybride s’impose comme réponse à des besoins contradictoires : scalabilité d’un côté, souveraineté de l’autre ; ouverture des API, mais contrôle des données ; performance globale, tout en maintenant des traitements à proximité des usages.

Sur le plan technique, le cloud hybride désigne l’intégration d’environnements publics (AWS, Azure, GCP), privés (on-premise, virtualisation interne, cloud souverain) et, désormais, de périphéries distribuées (edge computing, IoT, 5G).

Ces couches interopèrent, orchestrées par des outils capables d'unifier leur gestion sans masquer leurs spécificités.

Dès lors, plusieurs enjeux émergent :

Orchestration multi-environnement : comment gérer des clusters Kubernetes répartis entre plusieurs clouds, tout en conservant une logique d’infrastructure unique ?

Sécurité étagée : segmentation réseau, secrets chiffrés, IAM granulaire… chaque niveau de l’architecture impose ses contraintes et ses vecteurs d’exposition.

Latence et performances : certaines charges ne tolèrent ni rebond géographique, ni traitement différé. Le cloud hybride donne la main pour rapprocher le calcul des besoins.

En 2025, les dépenses mondiales consacrées à l’edge AI devraient dépasser 260 milliards de dollars en 2025, portées par une adoption massive dans la vente au détail, l’industrie manufacturière, la santé et la haute technologie.

Edge computing : le traitement à la périphérie du réseau

L’edge computing introduit une nouvelle strate : des unités de calcul embarquées dans les objets, à la frontière du SI, à proximité des capteurs, utilisateurs ou machines. Ces unités (gateways, micro-serveurs, modules ARM ou appliances industrielles) prétraitent, filtrent, décident, voire réagissent sans solliciter le cloud principal.

Cette approche soulève plusieurs impératifs techniques :

Orchestration déportée : K3s, MicroK8s, Azure IoT Edge… chaque edge node doit s’enregistrer, se mettre à jour, être supervisé à distance.

Résilience locale : perte de réseau, panne cloud, déconnexion temporaire ? L’edge doit continuer à fonctionner de façon autonome.

Sécurité intégrée : peu de surfaces, beaucoup d’exposition. Authentification forte, mise à jour OTA, chiffrement des flux : rien ne se tolère en clair.

DevOps : catalyseur des transformations cloud

Aucune de ces architectures n’a de sens sans automatisation, sans versioning, sans supervision, et redéploiement. Le DevOps incarne précisément ce socle technique et culturel. Il relie les environnements, fluidifie les cycles de déploiement, fiabilise les configurations, structure la scalabilité.

Son rôle devient encore plus central lorsque les environnements se fragmentent. Dans un contexte hybride ou edge, le DevOps pilote l’hétérogène. Il maintient l’unité de gouvernance tout en épousant la diversité des couches techniques.

Vous cherchez une offre de mission ou d'emploi en tant que DevOps ?

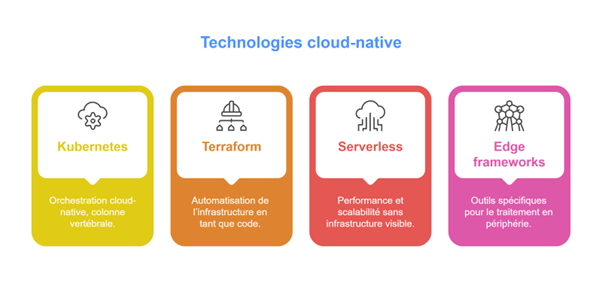

Technologies incontournables en 2025 pour piloter un SI hybride et distribué

Kubernetes : colonne vertébrale de l’orchestration cloud-native

Impossible d’ignorer Kubernetes. En 2025, il fédère les workloads, gère la haute disponibilité, orchestre les microservices et aligne les déploiements sur les exigences métiers. Sa force : une extensibilité redoutable, adaptée aux contextes cloud, hybrides et edge.

Déploiement multi-cloud et edge avec K3s, KubeEdge, OpenShift

K3s simplifie le déploiement en périphérie : léger, optimisé pour l’embarqué, il tourne sur des Raspberry Pi comme sur des gateways industrielles.

KubeEdge pousse l’intégration plus loin : les workloads edge deviennent des extensions natives du cluster principal.

De leur côté, OpenShift et Tanzu proposent une gestion cohérente des clusters entre on-premise, cloud public et edge, tout en apportant leur propre couche de sécurité et de CI/CD.

Sécurité et observabilité

Un cluster Kubernetes mal gouverné devient un terrain d’attaque idéal. Le contrôle d’accès (RBAC), la politique d’admission (OPA/Gatekeeper) et la segmentation réseau (Calico, Cilium) assurent l’isolation des workloads sensibles.

Le triptyque SLO / Alerting / Visualisation forme une base de pilotage indispensable pour anticiper les dérives et réagir à chaud.

Gestion des mises à jour et du scaling

Les versions de Kubernetes évoluent vite. Un bon workflow intègre des mises à jour sans interruption, avec rollback automatique (via Helm ou Argo Rollouts).

Horizontal Pod Autoscaler, Cluster Autoscaler ou KEDA permettent d’ajuster dynamiquement la charge, en réponse à des événements internes ou externes.

Terraform & Infrastructure as Code : fondation de l’automatisation

Déploiement multi-environnement

Terraform gère les déploiements sur AWS, Azure, GCP, mais aussi sur VMware, OVHcloud, Oracle ou Scaleway. Les modules réutilisables assurent la cohérence entre environnements (dev, staging, prod), tandis que les workspaces permettent d’isoler les états sans dupliquer le code.

Un module bien conçu suit une logique DRY (Don’t Repeat Yourself), accepte des variables explicites et typées et expose des outputs clairs et documentés.

Serverless & FaaS : performance et scalabilité sans infrastructure visible

Le serverless a changé la donne. Finis les serveurs à maintenir, les VM à patcher. Place aux fonctions éphémères, activées à la volée par des événements.

Fonctionnement : AWS Lambda, Azure Functions, Google Cloud Run

Ces services facturent à l’exécution, scalent automatiquement, s’intègrent aux écosystèmes cloud. Lambda, pionnier historique, se lie à plus de 200 services AWS. Azure Functions se connecte naturellement à EventGrid et Logic Apps. Cloud Run, fondé sur Knative, accepte des conteneurs et supporte HTTP natif.

Edge frameworks

Les workloads edge nécessitent un outillage spécifique : léger, tolérant à l’instabilité réseau, capable de mise à jour OTA.

Outils :

K3s : Kubernetes allégé, pensé pour tourner sur ARM.

MicroK8s : tout-en-un, avec plug-ins activables, idéal pour prototypage local.

Balena : pour déployer des conteneurs sur des parcs IoT massifs.

Azure IoT Edge : gère modules conteneurisés, communication avec IoT Hub, traitement local des flux.

Par ailleurs, un device doit fonctionner même isolé. D’où la nécessité d’intégrer une logique de fallback local (base de données embarquée, décision autonome), un chiffrement bout en bout et une identité unique signée et vérifiable.

Quelles compétences pour tirer parti de ces technologies ?

1️⃣ Maîtrise des stacks modernes d’infrastructure

Concevoir une infrastructure hybride performante exige bien plus qu’un enchaînement de briques techniques. Cela implique une vision modulaire, évolutive, et surtout contextualisée.

L’ingénieur DevOps moderne structure ses architectures autour de plusieurs dimensions :

Modularité : composants loosely coupled, microservices conteneurisés, gestion fine des dépendances.

Scalabilité : autoscaling horizontal, découplage via message brokers, stateless by design.

Résilience : tolérance aux pannes, reprise rapide, redondance géographique.

Tout ne s’automatise pas à l’identique. Certaines charges nécessitent des clusters Kubernetes hautement disponibles. D’autres profitent d’un burst ponctuel via du serverless, ou d’un traitement localisé sur des nodes edge.

2️⃣ Savoir coder l’infrastructure

Décrire son infrastructure dans des fichiers versionnés, audités et reproductibles ne relève plus du luxe. C’est devenu un standard opérationnel. Terraform, Ansible, Pulumi… tous obéissent à une logique commune : déclaratif, traçable, automatisé.

Les pipelines modernes s’articulent autour de trois piliers :

Git comme source unique de vérité,

CI/CD comme moteur de test et de déploiement,

GitOps comme garant de la synchronisation entre code et production.

Un ingénieur DevOps aguerri sait concevoir des pipelines reproductibles : tests unitaires sur l’infra, déploiements conditionnels, rollback intégré. Il outille sa chaîne avec GitHub Actions, GitLab CI, ou Argo CD pour garantir la continuité des flux, du commit au cluster.

3️⃣ Monitoring et observabilité distribuée

Pas d’automatisation sans visibilité ! On ne pilote pas un SI fragmenté sans une instrumentation précise, interopérable et distribuée.

Des outils comme Prometheus (collecte des métriques à intervalle régulier) et Grafana (dashboards personnalisés) permettent de monitorer l’état de santé des services, de visualiser les performances en temps réel et d’anticiper les dégradations avant qu’elles n’impactent les utilisateurs.

4️⃣ Sécurité intégrée et Zero Trust

Dès le design, chaque élément de sécurité doit respecter des règles explicites, centralisées et auditables.

En environnement Kubernetes ou serverless, l’enjeu réside dans l’application systématique des principes Zero Trust. Aucun workload ne mérite la confiance par défaut. Chaque appel, chaque accès, chaque déploiement doit se vérifier, se tracer et se restreindre au strict nécessaire.

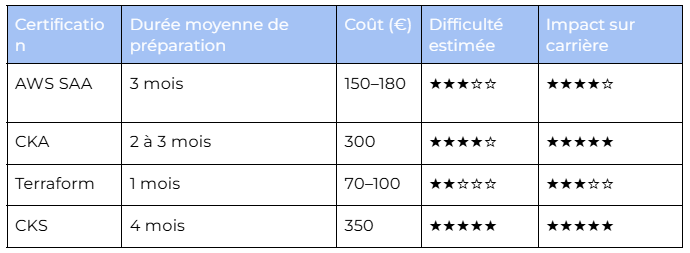

Certifications, veille et formation continue : structurer une montée en compétences durable

Certifications les plus valorisées en 2025

Face à la densité des technologies cloud, les recruteurs ne cherchent plus seulement un « DevOps ». Ils scrutent la précision du profil : quelles expertises ? Quel niveau d’autonomie ? Quelle profondeur sur une stack donnée ?

Certaines certifications renforcent la crédibilité. D’autres ouvrent la voie à des postes seniors, à l’architecture ou au management technique.

Voici les plus stratégiques en 2025 :

Cloud généralistes

AWS Certified Solutions Architect (Associate / Professional)

Microsoft Azure Administrator / Architect

Google Cloud Professional Cloud Architect

Spécifiques DevOps / Infrastructure

Certified Kubernetes Administrator (CKA) : administration de clusters

Certified Kubernetes Security Specialist (CKS) : sécurité des workloads

Terraform Associate : infrastructure as code avancée

GitLab Certified CI/CD Specialist : CI/CD dans un contexte DevOps

Edge & IoT

Cisco Industrial Networking Specialist / Edge Solutions Specialist

Comparatif de quelques certifications :

Un choix pertinent de certification confirme une expertise, mais signale surtout une capacité d'apprentissage structuré et une rigueur opérationnelle. Sur un marché où la polyvalence technique ne suffit plus, cet atout devient capital.

Les 3 points clés à retenir :

Maîtriser Kubernetes, Terraform, le serverless et les frameworks edge constitue un socle indispensable pour piloter un SI hybride moderne.

Les compétences recherchées en 2025 dépassent la technique : automatisation, sécurité intégrée, observabilité distribuée et GitOps deviennent des standards.

Les certifications ciblées (CKA, Terraform…) structurent la montée en compétences et renforcent la valeur des profils sur un marché ultra-concurrentiel.

Commentaire (1)

Connectez-vous ou créez votre compte pour réagir à l’article.