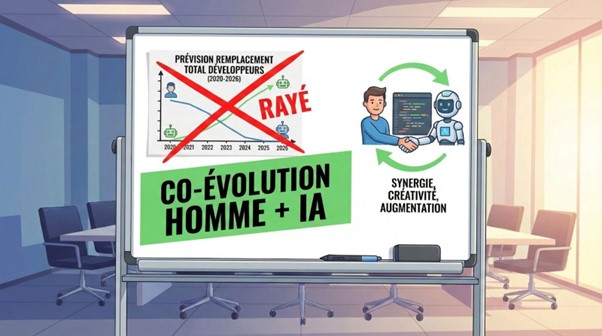

Remplacement des développeurs par l’IA : les prévisions ne tiennent plus la route

Les prophéties sur la disparition des développeurs ont un point commun : elles vieillissent mal. Pas parce que l’IA recule. Parce que le réel, lui, résiste. Entre un snippet qui compile et un produit qui survit à six mois de prod, il y a des incidents, des arbitrages, des équipes, des contraintes, de la dette - bref, du logiciel. Cette fois, même les auteurs des prévisions revoient leur copie, et l’aveu vaut presque plus que la date.

Pourquoi les prédictions sur la « fin des développeurs » ne riment à rien

Là où certains modèles plaçaient l’automatisation complète du dev entre 2027 et 2028, la version révisée bascule vers un horizon début des années 2030 pour un « superhuman coder », puis quelques années plus tard pour une chaîne plus complète.

Ce glissement ne raconte pas une IA qui stagne. Il raconte autre chose : la différence entre une capacité démontrée et une autonomie réelle. Un modèle peut résoudre des tâches de code impressionnantes, générer une PR propre, corriger des tests. L’autonomie, elle, exige une tenue dans la durée.

Et puis il y a le phénomène médiatique, toujours le même. Une phrase « super-codeur en 2031/2032 » se transforme en titre « fin des devs », puis en débat binaire.

Le public retient la date. Les équipes, elles, retiennent une autre info, plus utile : même les modèles sérieux changent vite de trajectoire quand on retouche deux hypothèses.

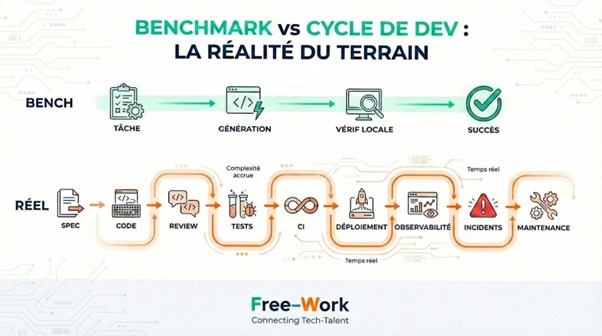

Le biais des benchmarks IA appliqués au code

Les benchmarks de type « coding tasks » font briller l’IA… et ils l’enferment dans une boîte. En effet, ils évaluent des tâches bornées, avec un objectif clair, des signaux de réussite lisibles, un contexte réduit.

Dans un vrai SI, le contexte déborde : dépendances, politiques de sécurité, conventions d’équipe, services amont, erreurs de spec...

D’où un classique vécu par presque tout le monde en dev : « 80 % fonctionnel » ne vaut pas « prêt prod ». Il manque souvent le grain qui fait toute la différence : idempotence, gestion d’erreurs, perf sous charge, logs exploitables, métriques, migrations, rollback, compatibilité, droits, conformité, etc.

Autre illusion : le « super-codeur » isolé. Le logiciel moderne ressemble rarement à un atelier artisanal ; il s’appuie sur des systèmes distribués, des équipes, des contrats d’API, des pipelines CI/CD, des SLO, des incidents.

Un benchmark mesure un sprint sur piste. Le réel impose une course d’endurance en trafic urbain.

Le mythe du code autonome

Un produit logiciel ne ressemble pas à un PDF. Il bouge. Il évolue sous l’effet des usages, des incidents, des changements légaux, des dépendances externes.

Dès que la réalité entre dans la boucle — maintenance, dette, migrations, incidents — l’IA perd son avantage instantané. Elle excelle sur le statique : comprendre un fichier, générer un module, proposer une refacto locale. Pour autant, elle trébuche sur le dynamique : interactions, drift, comportements émergents, arbitrages en contexte.

Les équipes SRE connaissent la musique : une stack tient grâce à des boucles d’observabilité, des postmortems, des décisions de fiabilité. Rien de glamour. Beaucoup de rigueur. Et un ancrage dans le réel qui résiste très bien aux prophéties !

Une bascule discrète : l’IA ne remplace pas, elle déplace la valeur

Ce qui se raréfie : le code « jetable »

Pendant des années, le marché récompense l’exécution rapide : livrer un CRUD, exposer trois endpoints, brancher un ORM, poser une UI correcte. Aujourd’hui, cette zone perd de son prix. L’IA génère du squelette à la chaîne, les frameworks industrialisent déjà le reste, et les plateformes « prompt → app » compressent encore le délai.

Le résultat se lit dans la chaîne de valeur : moins d’avantage compétitif sur le code simple. Une feature « standard » ressemble à une commodité. De facto, le différentiel ne vient plus du volume de lignes, mais du niveau de confiance et du degré d’alignement avec le système cible : conventions, sécurité, perf, exploitation.

Cette commoditisation frappe d’abord les applications éphémères : démos, back-offices basiques, outils internes sans exigences fortes, prototypes jetés après validation. C’est rapide, spectaculaire, parfois utile. Et rarement durable.

Les profils juniors généralistes prennent la vague de face. Non pas parce que « le junior ne sert plus », mais parce que la rampe d’entrée change : on attend une capacité à produire avec l’IA, puis à relire, corriger, sécuriser, instrumenter.

Et à comprendre ce que le code déclenche en aval. Les signaux marché confirment la tension côté junior, avec un affaiblissement de la demande sur ce segment dans plusieurs baromètres.

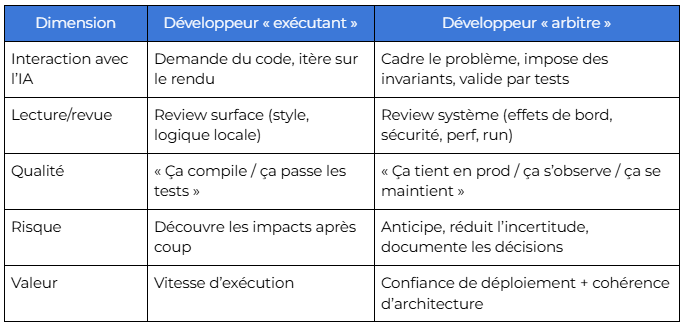

Ce qui monte en puissance : compréhension, arbitrage, responsabilité

Quand l’IA crache du code, une compétence devient rare : lire vite, juger juste. Une PR « propre » peut masquer un piège : état partagé mal maîtrisé, gestion d’erreurs incomplète, hypothèse implicite, perf qui se dégrade sous charge. Le code « semble logique ».

Un autre point change la donne : challenger l’IA. Pas prompt-er mieux pour gagner du style. Challenger au sens technique : reformuler les contraintes, exiger des invariants, refuser une solution fragile, demander des tests pertinents, imposer des garde-fous de sécurité.

C’est là que le rôle glisse vers du design décisionnel. Le développeur cesse d’incarner un simple exécutant. Il arbitre. Il sélectionne. Il tranche entre trois compromis imparfaits, puis il assume l’impact en run : observabilité, incidents, rollback, dette.

Les chiffres récents illustrent bien ce déplacement : adoption massive d’outils IA côté dev, mais vérification qui ne suit pas au même rythme. Sonar décrit un « verification gap » : une large part des développeurs n’accorde pas une confiance totale au code généré, tout en vérifiant moins qu’attendu avant commit.

Le paradoxe du marché : moins d’ouvertures, plus d’exigence

Le marché envoie deux messages qui se contredisent… en apparence.

D’un côté, les volumes se contractent sur une partie des postes tech, avec une faiblesse prolongée des annonces dans certains pays depuis le pic post-pandémie. Indeed note une baisse marquée des offres tech par rapport aux niveaux de référence, et LinkedIn pointe un affaiblissement spécifique de la demande junior, alors que les rôles liés à l’IA restent très disputés.

De l’autre, l’usage de l’IA dans le dev se généralise. Stack Overflow mesure une progression nette : une majorité de développeurs déclare utiliser des outils IA ou planifier leur usage, avec une hausse entre 2024 et 2025.

Le paradoxe se résout en réalité rapidement : l’exigence grimpe plus vite que les effectifs. On demande moins de bras à code, davantage de profils capables de livrer sous contrainte.

Autrement dit, le tri se fait sur la capacité à réduire le risque et à accélérer sans casser.

Pourquoi une IA ne remplace pas un développeur au sein d’une organisation

Le développement ne se réduit pas à un acte technique : il matérialise une organisation

Le code ne tombe pas du ciel. Il fixe des décisions : ce que l’on mesure, ce que l’on journalise, ce que l’on chiffre, ce que l’on refuse, ce que l’on tolère. Une IA peut produire une implémentation. Elle ne porte pas la décision qui l’entoure.

Dans une entreprise, le logiciel naît d’arbitrages économiques (budget, délai, ROI), politiques (priorités, périmètre, ownership), humains (adoption, support, formation), et techniques (dette, compat, perf). Le code est un exercice de compromis, pas un exercice académique.

Ajoutons la coordination inter-équipes. Tout cela réclame de la négociation. Une IA n’arrive pas en comité d’architecture, n’obtient pas l’accord d’une équipe sécurité, n’aligne pas un produit et un runbook.

Responsabilité légale, sécurité, dette : l’angle mort des discours IA

Dès qu’un bug touche des données perso, des paiements, une identité, une indisponibilité majeure, une question surgit : qui endosse la responsabilité ? L’outil génère. L’organisation répond. Le fournisseur du modèle ne signe pas vos mises en production.

Côté cadre réglementaire, l’Europe encadre l’IA via l’AI Act, avec des obligations qui varient selon le risque, et une logique de gouvernance et de traçabilité qui intéresse directement les usages en entreprise.

Sur le plan sécurité, « secure by design » ne sort pas d’un prompt ; un générateur propose souvent des patterns plausibles. Mais il ne connaît pas vos menaces, vos secrets, vos politiques, vos contraintes réseau. Les signaux récents ne manquent pas : vulnérabilités liées à du vibe coding, fuites dues à des erreurs de base, adoption qui dépasse les pratiques de vérification.

Et puis la dette s’accumule. Une orga qui laisse l’IA produire vite sans renforcer revue, tests, SAST/DAST, threat modeling, observabilité… achète une dette de vérification.

Le mythe de la disparition, la réalité de la mutation

Les prévisions bougent, parfois brutalement. Le métier, lui, ne s’éteint pas : il se recompose.

L’IA écrase la valeur du code simple et accélère le prototypage, c’est un fait. En parallèle, elle renchérit la valeur de ce qui ne s’improvise pas : arbitrage, fiabilité, sécurité, exploitation, responsabilité.

Les rôles rigides perdent du terrain. Les profils capables de cadrer, relire, sécuriser, instrumenter, puis assumer en run gagnent en gravité. In fine, l’IA ne remplace pas « le développeur ». Elle remplace l’idée d’un développeur réduit à l’exécution pure.

Commentaire (1)

Connectez-vous ou créez votre compte pour réagir à l’article.