Les 6 meilleurs serveurs MCP pour le DevOps

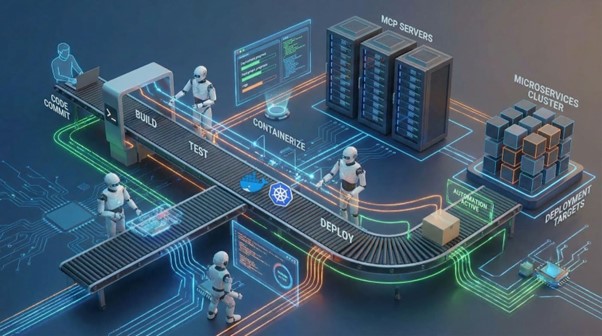

On a intégré des LLM dans nos IDE, branché des prompts dans nos workflows, remplacé trois scripts Bash par une phrase en anglais. Et pourtant, sans serveur MCP, l’IA reste spectatrice. Ces serveurs forment une nouvelle couche : pas une API de plus, pas une surcouche cosmétique, mais un vrai pivot d’architecture DevOps. Ils traduisent des intentions en actions. Ils savent où agir, avec quoi, et jusqu’où. Voici pourquoi ils méritent enfin une place au chaud dans votre pipeline.

Le MCP à la loupe

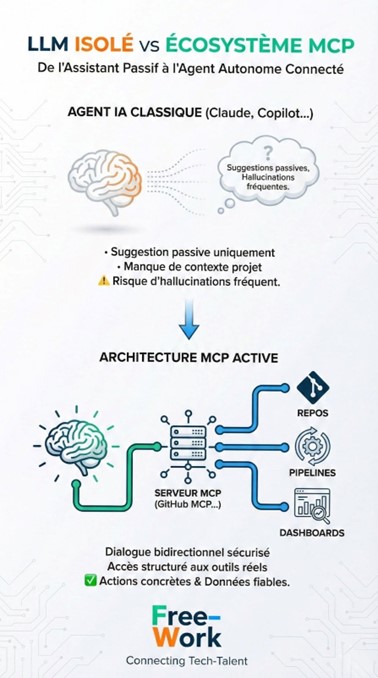

Le Model Context Protocol, ou MCP, est un standard ouvert, soutenu par plusieurs acteurs de l’IA générative (dont Anthropic), conçu pour une seule chose : outiller les agents IA, au plus près des usages métiers.

Pas une couche d’abstraction en plus. Une interface opérationnelle, structurée par des schémas, des outils et des permissions explicites.

À la différence d’un LLM isolé qui génère sans rien voir, un agent outillé par MCP interagit avec les outils DevOps, de manière ciblée, documentée, traçable. Il peut explorer un pipeline, remonter une alerte Grafana, interroger un registre Terraform ou extraire un ticket Jira.

Précisons également que MCP ne remplace pas les API REST, ni les CLI. Il les encapsule avec un schéma d’usage intelligible pour les LLM.

Là où l’API attend une requête structurée, le MCP écoute une intention. Là où le SDK exige un setup, le MCP interagit à distance. Et contrairement aux plugins IDE, MCP ne se limite pas à l’IDE. Il vit côté serveur, avec des permissions précises, dans un contexte d’exécution maîtrisé.

Serveur MCP vs client MCP : qui fait quoi, et surtout comment ?

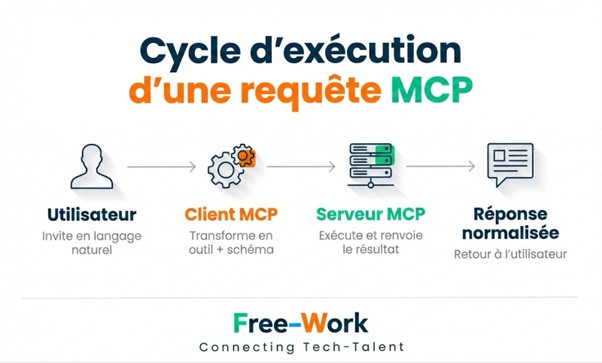

Le protocole repose sur deux entités bien distinctes.

Le serveur MCP, c’est la porte d’entrée vers un outil ou une API. Classiquement, il expose :

une liste d’outils (ex. list_pipelines, get_alert_logs)

des schémas d'entrée et de sortie JSON

des permissions déclaratives (lecture seule, action contrôlée, etc.)

Ce serveur ne décide rien. Il s’exécute localement ou à distance, selon vos préférences d’architecture.

Le client MCP, en revanche, interprète les intentions exprimées par l’utilisateur (ou l’agent IA). Il convertit une phrase en requête.

Exemples de clients : Claude AI, GitHub Copilot, Cursor, Windsurf, Zed, Sandpack AI, etc.

Ce sont eux qui traduisent :

« Liste les tickets ouverts dans mon sprint »

→ en appel structuré vers l’outil list_active_issues du serveur MCP Atlassian.

Dans cette logique, la responsabilité de l’action est partagé :

le client émet l’intention (enrichie par le LLM),

le serveur exécute uniquement ce qu’il a le droit d’exécuter, selon les outils, les schémas et les scopes exposés.

Top 6 des serveurs MCP à suivre en 2026

1️⃣ Azure DevOps MCP Server

Quand un agent IA reçoit une invite du type :

« Liste les PR ouvertes sur le projet X, classées par reviewer », le serveur MCP Azure DevOps prend le relais.

Ce serveur expose les APIs Azure via des outils structurés, avec une gestion fine des work items, des pipelines CI/CD, des pull requests, des audits ou encore des artefacts.

L’approche « retrieve then reason » structure les requêtes en deux phases :

Récupération ciblée des éléments du contexte (pull requests, commits…)

Analyse générative côté agent IA.

Par ailleurs, la consommation de tokens est optimisée grâce à une réponse JSON compacte, conçue pour les LLM. Les appels ne renvoient que les champs nécessaires à la tâche, réduisant les coûts et améliorant la pertinence.

Même dans des environnements hybrides (Azure + GitHub, Azure + On-prem), ce serveur reste pertinent via des outils comme get_deployment_status, audit_pipeline_results, ou list_unlinked_workitems.

2️⃣ GitHub MCP Server

GitHub n’a pas attendu pour outiller ses IA. Son serveur MCP, désormais mature, expose un spectre fonctionnel impressionnant :

récupération de PR ouvertes ou mergées,

analyse et mise à jour d’issues,

accès aux Actions en cours ou passées,

gestion de projet par metadata.

Un agent IA correctement branché peut trier des pull requests par reviewer ou par statut, identifier des conflits ou des workflows échoués, commenter automatiquement une PR si un test échoue, lier une issue à une release validée...

Deux modes d’usage cohabitent :

lecture seule (très utilisée pour l’audit, la documentation, les dashboards dynamiques),

mutation contrôlée, avec des outils explicitement autorisés (create_issue, comment_pull_request, cancel_workflow_run).

Ce serveur devient particulièrement pertinent pour :

la revue de code automatisée (analyse + commentaire dans la PR),

les audits de sécurité (scan des métadonnées, recherche d’alertes ou de tokens exposés),

ou la gouvernance CI/CD (visualisation du graphe d’exécution, des droits d’accès, etc.)

3️⃣ GitLab MCP

Pour les entreprises GitLab-first, ce serveur MCP offre une orchestration native des projets, pipelines et artefacts.

Il repose sur une logique proche de GitHub MCP, avec quelques spécificités notables :

Recherche contextuelle multi-projets : un agent IA peut interroger des tickets, commits ou pipelines sur plusieurs repos à la fois.

Actions autorisées : création de ticket, fusion de MR, analyse de différences, récupération d’un log de pipeline.

Compatibilité OAuth 2.0 dynamique, très appréciée pour les environnements segmentés.

Contrairement à GitHub MCP, la couche Actions n’existe pas. GitLab mise sur son propre pipeline YAML, que le serveur expose sous forme d’outils (get_pipeline_jobs, list_merge_requests, get_commit_diff...).

Ce serveur brille dans des cas d’usage où les contextes projet changent rapidement, ou lorsqu’un agent doit naviguer entre plusieurs groupes GitLab, sans configuration manuelle.

4️⃣ Argo CD MCP

Argo CD ne gère pas juste du déploiement Kubernetes. Via son serveur MCP, il expose toute la structure GitOps d’un projet à une IA.

Deux couches sont accessibles :

Les applications (ex : créer/supprimer/synchroniser une App),

Les ressources K8s sous-jacentes (ex : logs d’un Pod, statut d’un service).

Dès lors, un agent IA peut :

déclencher une synchronisation de staging,

lister les images utilisées dans un cluster,

expliquer pourquoi un Pod échoue,

ou vérifier la dérive entre Git et la prod.

Ce serveur offre aussi une visibilité enrichie, y compris sur les événements passés (get_app_events) ou les logs d’audit.

Complément idéal de kubectl, il n’en prend pas la place, mais s’en affranchit pour les tâches fréquentes ou répétitives. Et contrairement à l’UI Argo, il fonctionne en langage naturel, à distance.

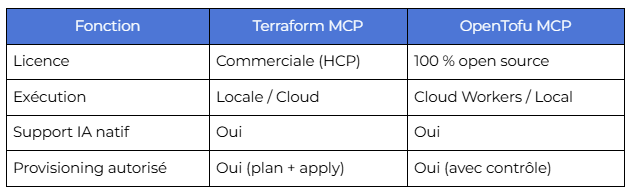

5️⃣ Terraform MCP

Avec le serveur MCP Terraform, l’agent IA ne génère plus seulement du code IaC : il provisionne, planifie, vérifie et surveille.

Les outils exposés permettent :

la génération contrôlée de runs,

l’inspection d’un workspace,

la récupération de modules, outputs ou providers.

Et surtout : l’humain reste dans la boucle. Chaque exécution peut être bloquée en mode plan-only, exigeant une validation avant application.

OpenTofu, le fork open source de Terraform, propose un serveur MCP équivalent mais mieux intégré à une infra cloud-first :

déploiement sur Cloudflare Workers,

support d’exécution en ligne,

schémas JSON plus détaillés.

OpenTofu MCP reste entièrement open source, contrairement à Terraform MCP qui impose Terraform Cloud/Enterprise pour certaines fonctions avancées.

6️⃣ AWS MCP Servers

Chez AWS, les serveurs MCP poussent la logique à fond. Ils exposent des dizaines de services sous forme d’interfaces MCP-ready.

Parmi les plus utiles pour DevOps :

Lambda MCP Tool : lister, invoquer ou debugger des fonctions serverless.

S3 Tables MCP : interroger des fichiers CSV comme des tables relationnelles.

Knowledge MCP : extraire documentation, références API ou architectures types.

Le principal avantage : l’optimisation native côté provider.

Les schémas sont à jour, les appels sont rapides, la scalabilité ne pose pas problème. En revanche, quelques bémols surgissent rapidement :

Dépendance forte à AWS : les outils MCP sont AWS-only.

Verrouillage possible : certains outils ne fonctionnent qu’avec IAM spécifiques.

Complexité croissante : peu documenté, écosystème mouvant.

Ces serveurs conviendront surtout à des équipes full-AWS, avec des besoins serverless, cloud-native ou orientés data.

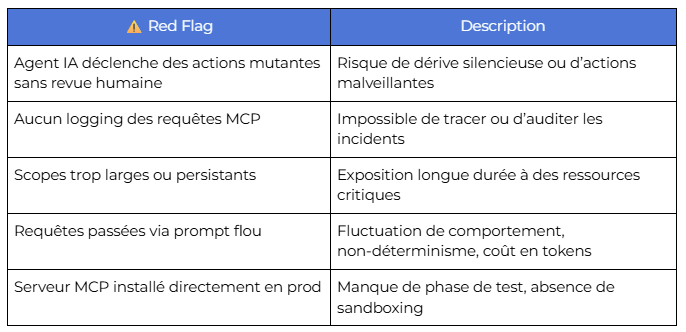

Quels sont les risques des serveurs MCP ?

Quand le MCP tourne à vide (ou court-circuite vos outils)

Pas besoin d’un serveur MCP pour lire un log Jenkins ou relancer un test. Si l’agent IA contourne la CLI, ralentit l’action ou ajoute une couche inutile d’abstraction, l’automatisation devient contre-productive.

⚠️ Premier piège : le contournement des interfaces standard.

Remplacer un kubectl logs par une invite qui traverse un LLM puis appelle get_pod_logs, c’est s’ajouter de la latence, des coûts, et un point de friction. Surtout si le contexte IA est mal fourni.

⚠️ Deuxième piège : la sur-automatisation.

Un agent qui synchronise automatiquement Argo CD dès qu’un commit est détecté ? Sans validation humaine, sans supervision ? C’est la recette parfaite pour un déploiement mal contrôlé, une régression en prod ou un incident muet.

⚠️ Troisième écueil : les comportements non déterministes.

Un LLM reste une boîte noire statistique. Ce qu’il exécute aujourd’hui ne sera pas forcément reproduit demain à l’identique. Et si l’agent « hallucine » une commande mutante sur un serveur MCP permissif, le coût se paie en prod.

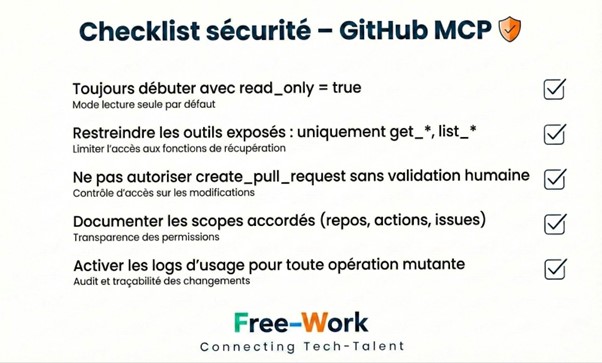

Sécurité, conformité, responsabilité : les angles morts à surveiller

Un serveur MCP mal configuré, c’est un agent IA avec un trousseau complet d’accès DevOps. IAM, Git, Kubernetes, pipelines, cloud… sans barrière.

Risques immédiats :

Fuites de secrets ou d’identifiants dans les logs ou les prompts,

Altérations non supervisées (merge, suppression, annulation),

Scopes IAM trop larges (permissions d’écriture sur toute l’organisation).

Côté conformité :

Les audits doivent tracer chaque action IA comme une action humaine.

Les journaux doivent consigner les requêtes, les outils appelés, les résultats.

Sans traçabilité, aucune certification DevSecOps ne tient.

FAQ technique : questions concrètes sur les serveurs MCP

À quoi sert concrètement un serveur MCP en DevOps ?

À connecter vos outils DevOps à un agent IA via des interfaces standardisées. Il expose des fonctions (issues, pipelines, dashboards…) que l’IA peut interroger ou manipuler dans un cadre sécurisé, documenté, traçable. Il ne remplace pas les outils, il les rend exploitables en langage naturel.

Peut-on chaîner plusieurs serveurs MCP dans un seul flux ?

Oui. Un agent peut appeler GitHub MCP pour récupérer une PR, puis déclencher une analyse de sécurité via Snyk MCP, puis documenter le tout dans Notion MCP. Ce chaînage repose sur des requêtes séquentielles, chaque serveur répondant avec un format standard que le client peut enrichir.

MCP fonctionne-t-il dans des environnements on-prem ?

Oui, s’il est exécuté localement. Les serveurs MCP tournent en local (via Docker, Node.js, Deno, etc.) et ne nécessitent pas de déploiement cloud par défaut. L’agent IA peut pointer vers un endpoint sur localhost, tant que le schéma MCP est respecté.

Est-ce que MCP remplace les CLI ou pipelines existants ?

Non, et il ne faut pas qu’il le fasse. MCP s’appuie sur les CLI, les pipelines, les APIs, les scripts. Il les encapsule, les expose autrement. Le danger survient quand l’équipe délaisse les outils natifs au profit d’un pilotage IA non vérifié.

Commentaire

Connectez-vous ou créez votre compte pour réagir à l’article.