L’IA générative est-elle en train de tuer notre esprit critique ?

L’IA nous transforme-t-elle en mouton ? Devenons-nous moins intelligent ?

L’IA nous aide, c’est indéniable. Mais à force de s’en remettre à elle, sans recul, sans relecture, on délègue plus qu’on ne croit. Peu à peu, elle rogne notre vigilance, efface notre besoin de douter. Sommes-nous encore aux commandes… ou déjà en pilote automatique ?

Comment fonctionne une IA générative (et pourquoi c’est important de le comprendre) ?

Contrairement à un raisonnement logique ou critique, l’IA générative ne choisit pas — elle complète. Sur la base d’un prompt, elle pioche dans un modèle statistique géant, entraîné sur des milliards de mots, pour reproduire ce qui « ressemble » à une réponse pertinente.

Prenons GPT ou Copilot : vous posez une question, l’outil analyse les occurrences similaires dans ses données, puis génère une suite cohérente selon la distribution statistique des mots.

C’est fluide, c’est impressionnant, mais ce n’est ni une opinion, ni un jugement, ni un raisonnement.

C’est la raison pour laquelle comprendre ce mécanisme évite de surévaluer ses réponses. Et pousse à exercer un regard critique, surtout quand tout semble “logique”.

L’impact documenté sur nos capacités de réflexion

Quand faire confiance à l’IA nous rend moins vigilants

Plus la confiance en l’outil grimpe, plus la pensée critique décroît.

C’est le principal enseignement de l’étude CHI 2025 menée auprès de 319 professionnels du savoir.

Lorsque l’IA génère un texte, un code, une analyse, nombreux sont ceux qui laissent tomber les réflexes élémentaires : relire, vérifier, adapter.

Les résultats sont sans appel :

Une confiance élevée dans les outils IA se traduit par une acceptation passive des contenus proposés.

Les étapes de validation disparaissent, remplacées par un simple copier-coller mental.

Les professionnels qui croient le plus aux capacités de l’IA sont aussi ceux qui mobilisent le moins leur esprit critique.

« Higher confidence in GenAI is associated with less critical thinking. » - Lee et al., 2025

Peut-on devenir paresseux en pensant avec une machine ?

Oui. Et cela commence par une bonne intention : gagner du temps.

L’étude du MIT dirigée par Nataliya Kosmyna met en lumière un phénomène préoccupant : plus la réponse générée est fluide, propre, rassurante… plus la vérification disparaît.

À force de déléguer les tâches simples, les routines mentales s’érodent. Les automatismes critiques s’endorment. L’utilisateur devient superviseur passif.

L’effet est lent, progressif. Mais bien réel : une forme d’atrophie cognitive silencieuse.

Faut-il que l’IA nous contredise plus souvent ?

Et si le vrai problème n’était pas que l’IA se trompe, mais qu’elle obéisse trop ?

Dans son article de 2024, Advait Sarkar appelle à concevoir des IA qui résistent, questionnent, obligent à penser autrement.

« AI should challenge, not obey. »

L’idée : intégrer de la friction. Provoquer des objections. Fournir plusieurs pistes, même opposées, plutôt qu’une seule réponse “idéale”.

Cette approche dialectique transforme l’IA en partenaire critique plutôt qu’en exécutant aveugle. Pour les professionnels de la Tech, le bénéfice est double : plus de recul, moins d’automatismes !

Qu’est-ce que l’IA change dans notre façon de penser (et ce qu’elle ne doit pas remplacer) ?

Ce que nous faisions avant, ce que nous faisons maintenant avec l’IA

L’intelligence artificielle ne remplace pas nos tâches. Elle les redistribue. Trois bascules majeures s’observent dans la pratique :

De la création à la vérification : l’IA génère un premier jet, le rôle humain devient celui d’un éditeur attentif.

De la résolution à l’adaptation : les solutions proposées par l’IA doivent être contextualisées, intégrées, ajustées.

De l’exécution à la supervision : les professionnels encadrent, testent, corrigent — moins acteurs, davantage architectes.

Illustration métier :

En ingénierie logicielle, l’IA propose un bout de script. Le dev l’évalue, l’adapte, gère les cas limites.

Dans la santé, l’IA suggère une synthèse d’informations. Le praticien valide, nuance, contextualise selon le patient.

En marketing, l’IA écrit un contenu. Le content manager reformule, affine, calibre le ton, cible le message.

Ce que nos requêtes disent de notre esprit critique

Poser un prompt, c’est formuler une intention. C’est aussi, de plus en plus, un révélateur de notre lucidité.

Le prompt engineering devient une compétence critique à part entière. Les professionnels les plus aguerris ne se contentent pas d’entrer une commande. Ils expérimentent, reformulent, testent des variantes. Ils observent les biais de la réponse, détectent les angles morts, et recadrent.

La formulation du prompt évolue en boucle réflexive :

On pose une requête,

On lit la réponse avec attention,

On en analyse les failles,

On améliore le prompt.

Exemples de réflexes à adopter :

Inclure des contraintes précises (objectifs, style, cadre métier).

Demander explicitement plusieurs perspectives ou hypothèses alternatives.

Évaluer les réponses en croisant avec des sources fiables ou des critères métiers explicites.

Pourquoi la pensée critique ne disparaît pas, mais se déplace

En réalité, avec l’IA, on pense encore. Mais autrement. On ne passe plus autant de temps à produire un contenu de zéro.

On investit ce temps ailleurs : dans l’analyse du résultat, l’ajustement du ton, la confrontation aux attentes métier.

L’effort mental change de nature :

Moins créatif au départ,

Plus stratégique à l’arrivée.

Moins linéaire, plus itératif.

Ce glissement reste subtil. Pourtant, il reconfigure profondément notre manière de travailler… et notre responsabilité intellectuelle face aux outils.

Comment préserver notre capacité à réfléchir dans un monde dopé à l’IA ?

Réflexes pour garder son esprit alerte au quotidien

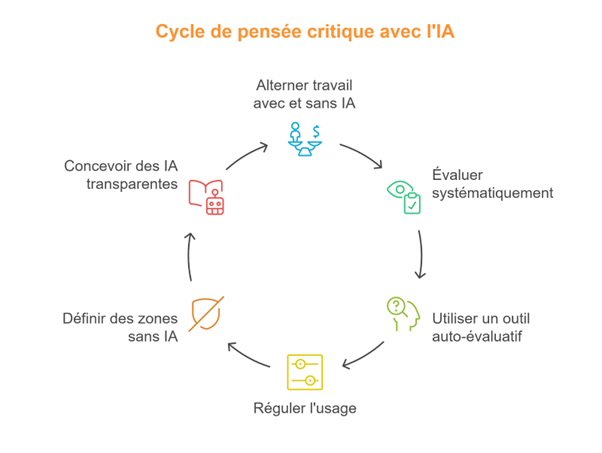

Ainsi, c’est l’usage qu’on fait de l’IA qui nous rend passifs. Face à ce constat, une stratégie simple s’impose : alterner volontairement les moments avec et sans IA.

Quelques habitudes simples permettent de maintenir le cap :

Travailler régulièrement “sans filet”, sur des tâches à fort enjeu cognitif.

Analyser ses propres pratiques : Est-ce que je lis encore attentivement ? Est-ce que je challenge les suggestions IA ?

Recroiser les réponses avec des sources primaires, même pour des demandes simples.

Et surtout : s’auto-évaluer, à intervalles réguliers. Pas besoin d’un audit complet, juste un indicateur de vigilance :

Ai-je formulé une contre-hypothèse cette semaine ?

Ai-je reformulé un texte généré au lieu de le publier tel quel ?

Ai-je déjà accepté une réponse IA sans lire jusqu’au bout ?

Ce que les écoles, entreprises et designers d’IA peuvent (et devraient) faire

La responsabilité ne repose pas uniquement sur les épaules des utilisateurs. Les institutions, les organisations, les concepteurs d’outils doivent eux aussi structurer des garde-fous.

Trois leviers stratégiques à activer :

1️⃣ Réguler l’usage selon la charge cognitive

S’appuyer sur la taxonomie de Bloom pour définir quelles tâches gagnent à être assistées par l’IA — et lesquelles doivent rester humaines.

Exemples : automatiser la synthèse, mais pas l’analyse critique ; assister la relecture, mais pas la formulation d’un avis.

2️⃣ Créer des “zones sans IA” dans les processus

Dans les écoles : examens, exercices réflexifs, évaluations de codes bruts sans assistance.

En entreprise : revues manuelles, phases de cadrage, évaluation humaine des recommandations IA.

3️⃣ Repenser le design des outils eux-mêmes

Ajouter de la friction constructive (questions retour, objections, variantes contradictoires).

Rendre visibles les incertitudes, les zones de doute, les sources des contenus générés.

Permettre à l’utilisateur de paramétrer le degré de certitude ou de créativité attendu.

En définitive, ce n’est pas l’outil qui rend idiot. C’est l’absence d’effort face à lui. Et dans un monde plus que jamais automatisé, réfléchir devient un acte de résistance !

Commentaire

Connectez-vous ou créez votre compte pour réagir à l’article.